Le journaliste se questionne : suis-je le prochain jalon de l'obsolescence programmée ?

Les médias doivent-ils flipper de l'IA ?

Oui.

Là tu te dis, il est gentil l'auteur de cet article. Mais c'est environ ce que tout le monde dit depuis la présentation de chat gpt au grand public. Super mon gars, enfonce des portes ouvertes vas-y.

Pourtant l'angle par lequel les journalistes abordent actuellement l'émergence des IA dans leur propre secteur d'activité est empreinte du prisme individualiste qui caractérise tout être humain qui sent diffusément qu'il est attaqué : ouf je survis, le malheur s'abat sur un autre. Ouf, le machin n'est pas encore au niveau, je gagne un sursis.

Vais je, moi journaliste, être remplacé par une intelligence artificielle en 2023?

Vais-je, moi professeur de sciences po formateur de l'élite journalistique, être berné par des travaux d'étudiants créés avec l'aide d'une intelligence artificielle? Vais-je être dépossédé d'une part de ma crédibilité académique à identifier les "bons éléments" capables de produire une réponse personnelle, les séparant des flemmards qui s'appuieront sur des réponses de intelligence artificielle ? ".

Oui.

Là tu te dis, il est gentil l'auteur de cet article. Mais c'est environ ce que tout le monde dit depuis la présentation de chat gpt au grand public. Super mon gars, enfonce des portes ouvertes vas-y.

Pourtant l'angle par lequel les journalistes abordent actuellement l'émergence des IA dans leur propre secteur d'activité est empreinte du prisme individualiste qui caractérise tout être humain qui sent diffusément qu'il est attaqué : ouf je survis, le malheur s'abat sur un autre. Ouf, le machin n'est pas encore au niveau, je gagne un sursis.

Vais je, moi journaliste, être remplacé par une intelligence artificielle en 2023?

Vais-je, moi professeur de sciences po formateur de l'élite journalistique, être berné par des travaux d'étudiants créés avec l'aide d'une intelligence artificielle? Vais-je être dépossédé d'une part de ma crédibilité académique à identifier les "bons éléments" capables de produire une réponse personnelle, les séparant des flemmards qui s'appuieront sur des réponses de intelligence artificielle ? ".

« l’utilisation, de ChatGPT à Sciences Po, ou de tout autre outil ayant recours à l’intelligence artificielle (IA) est, à l’exception d’un usage pédagogique encadré par un enseignant, pour l’instant strictement interdite lors de la production de travaux écrits ou oraux par les étudiants sous peine de sanctions qui peuvent aller jusqu’à l’exclusion de l’établissement voire de l’enseignement supérieur ».En gros suis je, moi professionnel des médias menacé dans l'expertise que requiert mon emploi par une intelligence artificielle ?

(courrier adressé à l'ensemble des étudiants le 25 janvier dernier)

Malgré une évolution indiscutable de la qualité des résultats proposés par cette technologie, ceux qui pensent que l'IA d'aujourd'hui est capable d'écrire un contenu provoquant la même émotion qu'un auteur se fourvoient :)

Albert Einstein disait : « L'imagination est plus importante que la connaissance. Car la connaissance est limitée, alors que l’imagination embrasse l’univers tout entier. »

Andréa Bensaïd sur son profil Linkedin

"Avec le buzz autour de ChatGPT, nous constatons une fois encore que ce ne sont pas forcément les plus grandes innovations scientifiques et technologiques qui font bouger les lignes, mais celles qui arrivent à frapper et mobiliser l'opinion. Finalement, ChatGPT, en faisant abondamment la une des journaux, a fait plus pour la promotion des avancées technologiques que toutes les grandes campagnes de sensibilisation. Si la technologie permet la viralité, la viralité sert aussi en retour la technologie !"

(Fabien Versaveau - Rakuten - dans Journal du Net

[les nouvelles technologies ] "Elles sont donc pertinentes pour certains usages, et pas pour d’autres. Le fait que la performance d’une nouvelle technologie soit inférieure sur certains critères et supérieure sur d’autres à la technologie existante explique ainsi pourquoi elle remplace rarement complètement cette dernière. Nous continuons à utiliser des fours traditionnels en plus des fours à micro-ondes, des avions à hélice et pas seulement des avions à réaction, des agendas papier et pas seulement électroniques, etc. Parfois, elle va rester inférieure sur les critères historiques (un téléphone mobile peut être à court de batterie ou perdre le réseau, au contraire d’un téléphone fixe), et parfois elle va finir par dépasser la technologie actuelle sur tous les critères, comme ce fut le cas pour la photographie numérique à partir des années 2000, auquel cas le basculement devient total et l’ancienne technologie disparaît." (...)

On tend à mettre en avant les inconvénients d’une nouvelle technologie plutôt que ses avantages. Parlez robots, on vous répond chômage. Parlez biotech et génétique, on vous répond Frankenstein. Parlez IA, on vous répond Skynet et domination des machines. Ce n’est pas nouveau. L’apparition de la photo a fait craindre la disparition des artistes, et de la radio celle des musiciens. On se focalise sur ce qui va disparaître, ou risque de disparaître, sans imaginer ce qui peut naître: le livre imprimé de Gutenberg a fait disparaître les magnifiques manuscrits enluminés, véritables ouvrages d’art, privant les moines copistes d’une source de revenu, mais il a ouvert la lecture et l’écriture à tous. Avec les livres, un érudit n’avait plus besoin d’apprendre les textes par cœur; il pouvait donc utiliser la capacité de son cerveau ainsi libérée pour des tâches bien plus créatives. Impossible de ne pas penser à un possible effet similaire pour ChatGPT, qui va nous libérer de certaines tâches pour nous permettre d’en faire d’autres.

(Philippe Silberzahn, professeur de stratégie à emlyon business school)

En l'état du mode de fonctionnement des IA génératives : le journaliste expert devrait être préservé

Tu as entendu parler des IA dites génératives, mais tu n'as pas très bien pigé comment ça fonctionne.

Sciences Etonnantes donne une explication vulgarisatrice de ce qu'est une IA dite générative.

Dans sa vidéo, il passe en revue les différentes techniques de génération d'images par algorithme. On y apprend par exemple que plusieurs techniques de création des modèles mathématiques d'intelligence artificielles sont en concurrence actuellement dans différents laboratoires.

Mais que c'est l'IA générative par méthode de "diffusion" qui fournit actuellement les résultats les plus bluffant pour l'entendement littéraire et artistique proche de l'univers média.

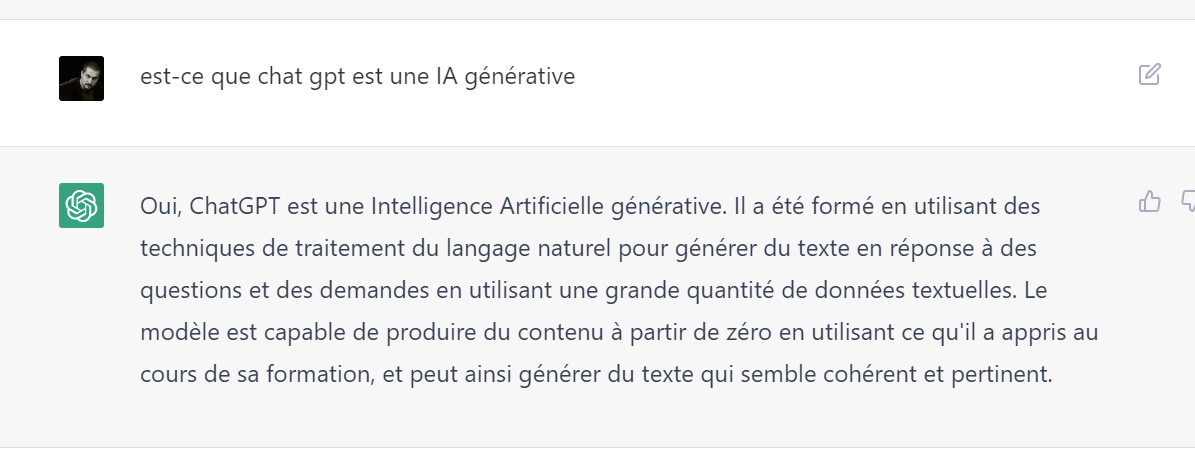

Alors vérifions. Est-ce que chat gpt , qui occupe toute l'information technologique, est une IA générative ? Faisons au plus simple. Demandons-lui.

Sciences Etonnantes donne une explication vulgarisatrice de ce qu'est une IA dite générative.

Dans sa vidéo, il passe en revue les différentes techniques de génération d'images par algorithme. On y apprend par exemple que plusieurs techniques de création des modèles mathématiques d'intelligence artificielles sont en concurrence actuellement dans différents laboratoires.

Mais que c'est l'IA générative par méthode de "diffusion" qui fournit actuellement les résultats les plus bluffant pour l'entendement littéraire et artistique proche de l'univers média.

Alors vérifions. Est-ce que chat gpt , qui occupe toute l'information technologique, est une IA générative ? Faisons au plus simple. Demandons-lui.

Chat GPT le roi de l'information "débruitée".

Si tu as suivi la vidéo ci-dessus tu comprends que la grande force de chat gpt et ses cousins en tant qu'IA génératives est de "débruiter" une thématique en arrivant à l'isoler et la circonscrire dans une série de d'ensembles textuels d'une base de données. Isolement d'autant plus efficace qu'elle a pu constater lors de l'entraînement par des humains quelle était la zone de sa base de données où se concentrent toutes les réponses usuelles aux questions posées relatives à cette dite thématique. Puis, une fois la délimitation effectuée, d'être ensuite capable d'"halluciner" des réponses crédibles

L'efficacité des IA génératives tient sur les piliers des deux critères majeurs qui en affermissent la pertinence: un périmètre de sélection efficace dans une base de données initiale riche de contenus, et un entraînement régulier à produire des "hallucinations" convaincantes en réponse à une thématique de recherche.

Sur des thèmes suffisamment documentés en amont, l'IA est donc capable d'aller identifier une zone de la base de données qui puisse servir de sac à réponses possibles, zone sur laquelle on l'entraîne à repérer les types et contenus de réponses les plus efficaces à donner, en tenant compte de la structure de la question posée par l'utilisateur (ce qu'on appelle le "prompt" de l'utilisateur). Puis de réagir en processant un format de réponse crédible parmi ce qu'elle a comme matière à disposition, en langage naturel.

Expérience bien entendu évolutive, enrichie par l'accumulation de formats de questions différentes posées par chaque utilisateur ayant un jour eu des demandes du même type. Et par l'affinement progressif de la base de données de thématiques.

En résumé : en allant piocher dans la base évolutive mondiale de données disponibles en ligne, et en l'entraînant sur un corpus dédié à la news, il sera très facile de demander à une IA de générer des papiers crédibles réponses à des questions ciblées factuelles.

Mais, à l'heure actuelle, pas encore capable de générer du contenu prédictif autonome, ni de faire oeuvre de recoupements prospectifs entre plusieurs facteurs ou plusieurs thèmes de sa base, reliés sans apparent lien logique. Incapable qu'est encore l'IA de compiler des thèmes ou des affects pour résoudre de façon novatrice une question posée en ce sens.

Cette création de "savoir" par la capacité à effectuer "la première analyse mise en ligne sur un sujet donné" reste à ce jour la part d'expertise acquise par un journaliste sénior ou d'un chargé de thématique dans les colonnes d'un journal sérieux.

Ce Journaliste (ou ce professeur si on parallélise avec la crainte des grandes écoles) est celui qui connait les faits mais peut aussi les améliorer de tout ce qui entoure les faits, lui qui peut relier tous les couacs qui se sont produits dans le passé similaires au fait, ou identifier l'atmosphère de l'époque quand se sont présentés des fait similaires. Il est aussi celui qui peut prédire l'impact d'événements extérieurs dans le déroulement de l'explication d'un sujet qu'il relate (le tempérament habituel d'un auteur de faits, le lien entre le fait et un autre qui s'est passé dans un autre domaine, la météo au moment du fait, la situation économique, etc). Dans ce défrichage, dans cette capacité analytique multifactorielle, l'IA ne peut pas encore rivaliser.

Au moins jusqu'à ce que paraisse en ligne le premier papier publié sur un topic précis. Une fois ce premier papier publié il peut alors servir de corpus pour l'IA générative. Cette courte avance entre l'homme et le réseau neuronal électronique est ce qui sauve à court terme, les métiers de production de contenu journalistique. Pour le moment, un vrai humain précède toujours le premier résultat possiblement re-généré ensuite par une machine, sur un sujet défini.

Pour le moment. Car avec l'expérience ou l'analyse des erreurs passées de l'IA sur elle-même, elle sera capable de produire des "suppositions" originales au moins aussi valables qu'un journaliste spécialiste de son sujet.

L'efficacité des IA génératives tient sur les piliers des deux critères majeurs qui en affermissent la pertinence: un périmètre de sélection efficace dans une base de données initiale riche de contenus, et un entraînement régulier à produire des "hallucinations" convaincantes en réponse à une thématique de recherche.

Sur des thèmes suffisamment documentés en amont, l'IA est donc capable d'aller identifier une zone de la base de données qui puisse servir de sac à réponses possibles, zone sur laquelle on l'entraîne à repérer les types et contenus de réponses les plus efficaces à donner, en tenant compte de la structure de la question posée par l'utilisateur (ce qu'on appelle le "prompt" de l'utilisateur). Puis de réagir en processant un format de réponse crédible parmi ce qu'elle a comme matière à disposition, en langage naturel.

Expérience bien entendu évolutive, enrichie par l'accumulation de formats de questions différentes posées par chaque utilisateur ayant un jour eu des demandes du même type. Et par l'affinement progressif de la base de données de thématiques.

En résumé : en allant piocher dans la base évolutive mondiale de données disponibles en ligne, et en l'entraînant sur un corpus dédié à la news, il sera très facile de demander à une IA de générer des papiers crédibles réponses à des questions ciblées factuelles.

Mais, à l'heure actuelle, pas encore capable de générer du contenu prédictif autonome, ni de faire oeuvre de recoupements prospectifs entre plusieurs facteurs ou plusieurs thèmes de sa base, reliés sans apparent lien logique. Incapable qu'est encore l'IA de compiler des thèmes ou des affects pour résoudre de façon novatrice une question posée en ce sens.

Cette création de "savoir" par la capacité à effectuer "la première analyse mise en ligne sur un sujet donné" reste à ce jour la part d'expertise acquise par un journaliste sénior ou d'un chargé de thématique dans les colonnes d'un journal sérieux.

Ce Journaliste (ou ce professeur si on parallélise avec la crainte des grandes écoles) est celui qui connait les faits mais peut aussi les améliorer de tout ce qui entoure les faits, lui qui peut relier tous les couacs qui se sont produits dans le passé similaires au fait, ou identifier l'atmosphère de l'époque quand se sont présentés des fait similaires. Il est aussi celui qui peut prédire l'impact d'événements extérieurs dans le déroulement de l'explication d'un sujet qu'il relate (le tempérament habituel d'un auteur de faits, le lien entre le fait et un autre qui s'est passé dans un autre domaine, la météo au moment du fait, la situation économique, etc). Dans ce défrichage, dans cette capacité analytique multifactorielle, l'IA ne peut pas encore rivaliser.

Au moins jusqu'à ce que paraisse en ligne le premier papier publié sur un topic précis. Une fois ce premier papier publié il peut alors servir de corpus pour l'IA générative. Cette courte avance entre l'homme et le réseau neuronal électronique est ce qui sauve à court terme, les métiers de production de contenu journalistique. Pour le moment, un vrai humain précède toujours le premier résultat possiblement re-généré ensuite par une machine, sur un sujet défini.

Pour le moment. Car avec l'expérience ou l'analyse des erreurs passées de l'IA sur elle-même, elle sera capable de produire des "suppositions" originales au moins aussi valables qu'un journaliste spécialiste de son sujet.

La fin de la "hot news" opérée par des humains.

Dès l'instant où on admet que dès la première mise à disposition d'un contenu humain sur une thématique, il sera possible à une IA de générer un discours sur le sujet... Il semble assez simple de se représenter qu'il suffira qu'existe une première dépêche d'agence sur un sujet pour permettre à une IA de bâtonner n versions de la présentation de ce fait, selon des prérequis contractuels entre le média et son service d'IA : "présente moi la news N°2585808 avec un ton et un vocabulaire qui adresse une population de professeurs des écoles qui apprécient France inter" .

Ou de compiler en un seul article sur un site média une actualité évoquée concomitamment par plusieurs agences AFP, Reuters, AP... Les transformant en un texte inédit qui synthétise les 3 agences de presse, avec un ton qui est hérité du média sur lequel cet article doit être publié. On est pile dans le champs d'application de l'IA générative à usage journalistique. Tremblez jeunes journalistes en quête de stage.

Bientôt le métier d' "enjoliveur" de dépêches sera effectué par Nono le petit robot journaliste. Un service facturé X euros par mois par, mettons, Flint de Benoît Raphaël qui s'est déjà créé un nom sur la compilation algorithmique de news. Là il s'agira non plus de les compiler mais de les écrire. Sous la supervision d'un chef de produit en charge de relire ce qui sort du robot Nono. De fait Il sera facile de "prompter" des routines pour trier les news sources à la demande du client et de lui fournir des résultats qui correspondent au cahier des charges commercial: "présente-moi un article d'un feuillet qui résume l'ensemble de ces hot news à propos du séisme en Syrie et Turquie, en t'appuyant sur le silo de l'AFP à la façon de *journaliste star du média*"

On a une zone de recherche délimitée dans une base de données circonscrites, et un corpus de potentielles manières de répondre d'une façon satisfaisante. Les réponses "hallucinées" par l'iA n'ont plus qu'à suivre une logique faits / vérification agrémentée de critères promptés en amont par un opérateur.

Le brio des agences d'IA journalistiques sera donc de fournir des "dompteurs et dompteuses d'iA" qui à l'instar de ce que produit ma pote "prompt artiste" Priscilla tordant à sa volonté les ressources d'OpenAI en génération d'images ; créeront les ordres "news" passés à l'intelligence artificielle. Leur travail consistera à trouver la commande, la recette, pour produire des articles factuels "hallucinés" ensuite par une machine, garantis corrects sur le fond et formellement parés pour le titre de presse dans lequel ils s'intégreront.

The Atlantic titrait d'ailleurs le 8 février dernier : "Votre job du futur pourrait dépendre de votre capacité à parler efficacement avec l'IA". En gros votre capacité à produire des prompts efficaces qui répondent entièrement au besoin de votre employeur - ou du lecteur final si on parle uniquement de contenu journalistique.

A tel point que c'est presque "ironique" de voir Buzzfeed aux US, par exemple, s'acheter une provisoire paix sociale en entreprise en faisant semblant que l'iA n'aura aucun impact sur l'art d'engager (ou de virer en l'occurrence) du personnel de sa rédaction. Alors que le titre vient d'annoncer vouloir utiliser l'outil automatisé pour commencer à produire du contenu. Mais des quiz hein promis. Juré craché. Buzzfeed résistera à la tentation d'articles saisonniers ou compilatoires produits par l'ia avec "le ton buzzfeed". Pas de "15 gadgets à offrir à noël" ou un article qui ressemble un tant soit peu à de la news. OK Pinocchio.

Les "points récap" sur un thème d'actualité qui font une part du trafic entrant sur nos sites et jadis même le business de sites comme Quoi.info : "les 10 smartphones d'entrée de gamme qui séduisent la France", "Belmondo quels sont les films préférés des Français", "Tout savoir des candidats du prix du livre Inter" pourront très probablement être automatisés. Et gagnent à l'être dans la logique actuelle du web : premier écrit premier visité.

Pourquoi payer des piges quand on peut payer un abonnement à une IA ?

Désolé les soutiers de l'info en temps réel. Chat GPT et ses cousins ne dorment pas, ont autant de bras que nécessaires, et il suffit d'un secrétaire de rédaction numérique pour vérifier que l'essentiel de ce qui est produit est correct.

MAIS:

La course est encore ouverte pour quelques temps, me semble-t-il, entre l'humain et les cousins IA s'agissant des articles de long format, ou d'analyse thématique. Eux qui continuent d'être opérés par des humains capables de créer le contenu "from scratch", "ex nihilo" face à des IA génératives qui sont obligées de partir d'un "bruit" initial qu'elles vont nettoyer en fonction de ce "qui a déjà été écrit sur le sujet".

"Vieux journalistes", chefs de rubriques spécialisés dans votre domaine de prédilection, rassurez-vous votre métier n'est pas encore mort comme on peut le lire dans plein d'articles angoissés parlant de remplacer l'écriture journalistique par un Bot... Et il sera encore épargné dans son potentiel, pour le moment.

Vous avez un doute? L'IA peut tout? Ok travaux pratiques. Je pose ici le prompt du sujet de cet article. Je laisse l'IA taffer (on est le 9 février elle a déjà un corpus de recherche sur la relation IA/médias) et je regarde en fin d'écriture si on a des point similaires, oui si mon analyse reste plus fine. Normalement on est pile dans le champ d'action de l'iA. Chat GPT fera-t-il mieux que moi qui nourrit mon propos d'une curation quotidienne et manuelle de l'actualité sectorielle. Suspense. (Clique sur la photo pour découvrir le résultat)

Ou de compiler en un seul article sur un site média une actualité évoquée concomitamment par plusieurs agences AFP, Reuters, AP... Les transformant en un texte inédit qui synthétise les 3 agences de presse, avec un ton qui est hérité du média sur lequel cet article doit être publié. On est pile dans le champs d'application de l'IA générative à usage journalistique. Tremblez jeunes journalistes en quête de stage.

Bientôt le métier d' "enjoliveur" de dépêches sera effectué par Nono le petit robot journaliste. Un service facturé X euros par mois par, mettons, Flint de Benoît Raphaël qui s'est déjà créé un nom sur la compilation algorithmique de news. Là il s'agira non plus de les compiler mais de les écrire. Sous la supervision d'un chef de produit en charge de relire ce qui sort du robot Nono. De fait Il sera facile de "prompter" des routines pour trier les news sources à la demande du client et de lui fournir des résultats qui correspondent au cahier des charges commercial: "présente-moi un article d'un feuillet qui résume l'ensemble de ces hot news à propos du séisme en Syrie et Turquie, en t'appuyant sur le silo de l'AFP à la façon de *journaliste star du média*"

On a une zone de recherche délimitée dans une base de données circonscrites, et un corpus de potentielles manières de répondre d'une façon satisfaisante. Les réponses "hallucinées" par l'iA n'ont plus qu'à suivre une logique faits / vérification agrémentée de critères promptés en amont par un opérateur.

Le brio des agences d'IA journalistiques sera donc de fournir des "dompteurs et dompteuses d'iA" qui à l'instar de ce que produit ma pote "prompt artiste" Priscilla tordant à sa volonté les ressources d'OpenAI en génération d'images ; créeront les ordres "news" passés à l'intelligence artificielle. Leur travail consistera à trouver la commande, la recette, pour produire des articles factuels "hallucinés" ensuite par une machine, garantis corrects sur le fond et formellement parés pour le titre de presse dans lequel ils s'intégreront.

The Atlantic titrait d'ailleurs le 8 février dernier : "Votre job du futur pourrait dépendre de votre capacité à parler efficacement avec l'IA". En gros votre capacité à produire des prompts efficaces qui répondent entièrement au besoin de votre employeur - ou du lecteur final si on parle uniquement de contenu journalistique.

A tel point que c'est presque "ironique" de voir Buzzfeed aux US, par exemple, s'acheter une provisoire paix sociale en entreprise en faisant semblant que l'iA n'aura aucun impact sur l'art d'engager (ou de virer en l'occurrence) du personnel de sa rédaction. Alors que le titre vient d'annoncer vouloir utiliser l'outil automatisé pour commencer à produire du contenu. Mais des quiz hein promis. Juré craché. Buzzfeed résistera à la tentation d'articles saisonniers ou compilatoires produits par l'ia avec "le ton buzzfeed". Pas de "15 gadgets à offrir à noël" ou un article qui ressemble un tant soit peu à de la news. OK Pinocchio.

M. Peretti s'attend à ce que l'IA aide le processus créatif et améliore le contenu de l'entreprise, tandis que les humains jouent le rôle de fournir des idées, une "monnaie culturelle" et des "incitations inspirées", a-t-il écrit dans son mémo. Dans 15 ans, a-t-il écrit, il s'attend à ce que l'IA et les données aident à "créer, personnaliser et animer le contenu lui-même", plutôt que de se contenter de gérer le contenu existant.La réalité est, au vu du rythme des annonces de boîtes comme Open AI ou LaMDA, (acronyme de language model dialogue applications) chez Google, que les classements des meilleurs hôpitaux où accoucher dans la région de Grenoble, la Syrie : histoire , qu'est-ce que le vaccin à ARN ? , quels sont les gestes barrière efficaces contre la grippe? Soit tous les articles qui peuvent s'appuyer sur un set de données source qu'il suffit de compiler et de traverser de questions liées à la compréhension du langage naturel vont très probablement séduire les cost killers de médias et remplacer des desk journalistes. Pas dans un avenir lointain. Lundi genre.

(Buzzfeed PDG -cité dans un article du WSJ en janvier dernier)

Les "points récap" sur un thème d'actualité qui font une part du trafic entrant sur nos sites et jadis même le business de sites comme Quoi.info : "les 10 smartphones d'entrée de gamme qui séduisent la France", "Belmondo quels sont les films préférés des Français", "Tout savoir des candidats du prix du livre Inter" pourront très probablement être automatisés. Et gagnent à l'être dans la logique actuelle du web : premier écrit premier visité.

Pourquoi payer des piges quand on peut payer un abonnement à une IA ?

Désolé les soutiers de l'info en temps réel. Chat GPT et ses cousins ne dorment pas, ont autant de bras que nécessaires, et il suffit d'un secrétaire de rédaction numérique pour vérifier que l'essentiel de ce qui est produit est correct.

MAIS:

La course est encore ouverte pour quelques temps, me semble-t-il, entre l'humain et les cousins IA s'agissant des articles de long format, ou d'analyse thématique. Eux qui continuent d'être opérés par des humains capables de créer le contenu "from scratch", "ex nihilo" face à des IA génératives qui sont obligées de partir d'un "bruit" initial qu'elles vont nettoyer en fonction de ce "qui a déjà été écrit sur le sujet".

"Vieux journalistes", chefs de rubriques spécialisés dans votre domaine de prédilection, rassurez-vous votre métier n'est pas encore mort comme on peut le lire dans plein d'articles angoissés parlant de remplacer l'écriture journalistique par un Bot... Et il sera encore épargné dans son potentiel, pour le moment.

Vous avez un doute? L'IA peut tout? Ok travaux pratiques. Je pose ici le prompt du sujet de cet article. Je laisse l'IA taffer (on est le 9 février elle a déjà un corpus de recherche sur la relation IA/médias) et je regarde en fin d'écriture si on a des point similaires, oui si mon analyse reste plus fine. Normalement on est pile dans le champ d'action de l'iA. Chat GPT fera-t-il mieux que moi qui nourrit mon propos d'une curation quotidienne et manuelle de l'actualité sectorielle. Suspense. (Clique sur la photo pour découvrir le résultat)

Mais la guerre à court terme ne se joue pas dans le remplacement du journaliste par l'IA

Chat GPT et ses potes ne vont sans doute pas flinguer, à court terme, tout le potentiel du métier de journaliste expert. Les IA pourraient tout de même faire disparaître le journalisme numérique, à très proche échéance si on ne s'active pas pour empêcher que cela n'arrive. Je m'explique.

La guerre de l'IA contre les journalistes, va se jouer à un échelon au dessus du "bout de chaîne" que représente la rédaction d'un article. C'est là qu'il faut se dépêcher d'agir.

Dans un monde de l'info divisé en deux où s'oppose information de service public de moins en moins dotée par les gouvernement et économie des médias privés, c'est plutôt dans l'équilibre instable de la valeur financière des contenus médiatiques que l'IA risque de faire le plus de mal, à très court terme. Demain.

Depuis les années 2000 le modèle des médias numériques n'a pas beaucoup changé si on prétend, comme je le fais ici, que le passage du gratuit avec publicité au modèle avec paywall n'a pas occasionné de révolution majeure des usages (seulement un peu de transformation de la sociologie des lecteurs de chaque titre payant).

Pour accéder à la news en tant qu'internaute, on va toujours majoritairement taper un thème de recherche dans un moteur de recherche et le géant de la recherche qui détient cet outil répond à notre demande en nous envoyant des liens de sites web en réponses plus ou moins efficaces à notre demande initiale.

Le fonctionnement du moteur de recherche star (Google) n'a pas beaucoup changé non plus pour notre écosystème média. L'utilisateur tape une requête dans une barre de requête et se voit présenter une série de résultats composés pour la plupart de liens, où l'utilisateur trouvera une réponse à sa question, plus ou moins efficace, plus ou moins circonscrite (et Google propose au passage plein de sites qui se sont positionnés en mots-clés comme étant la réponse idéale à ce type de questions droit acquis auprès du géant en payant très cher sa place en haut de liste de résultats) :

Tout est, depuis l'avènement des Gafam, affaire d'équilibre de pouvoir de générer des recettes et de balance du partage de revenus entre le fournisseur de chemin vers la news, et l'auteur de la news.

Les médias se sont donc battus pour pousser leurs liens vers les contenus dans chacun des silos des Gafam (la grande époque des médias financés par le visionnage de publicité, où plus de trafic entrant équivalait à plus de recettes publicitaires). Etre lu représentait un accroissement numéraire du nombre de publicités vues par l'internaute sur une page média. Il fallait donc être trouvable à chaque endroit où il était possible d'être trouvé.

Les Gafam en ont profité pour abuser de leur privilège de générateurs de volume et pour jouer aux dictateurs de formats, aux prescripteurs de règles ou de restrictions et de menaces de retirer les contenus du silo de leur walled garden.

Dans un second temps les médias privés et commerciaux se sont mis à tenter de rééquilibrer la relation entre celui qui croque financièrement au business de la redirection de trafic via recherche, et celui qui apporte du crédit, de la valeur aux recherches en fournissant un contenu news de qualité derrière chaque clic. Parce qu'investir dans un média, pour un investisseur, ça coûte cher. Et les perfusions étatiques ne permettent plus, ou à peine, d'augmenter les dividendes des actionnaires qui ont backé cet investissement.

Cette deuxième phase de l'internet des médias tenait pour acquis que le mode de fonctionnement de la recherche était gravé dans le marbre. C'était rigide comme des tables d'une loi tacite :

- Toi média tu te bats pour faire remonter ton lien en page 1 des moteurs de recherche,

- Toi média tu te bats avec Google pour qu'il partage un peu le brouzouf qu'il gagne sur les liens mis en exergue...

- Et toi consommateur tu cliques bien sagement sur les liens présentés en page une du moteur tu vas accepter les cookies tiers, acheter des contenus derrière des paywalls ou bouffer de la pub en préroll, avec un degré de satisfaction moyen. Degré de satisfaction bon pour le business de tout le monde puisqu'il t'amenait à passer d'un site à l'autre, d'un clic sur un résultat de recherche à l'autre.

Ce schéma d'usage semblait immuable.

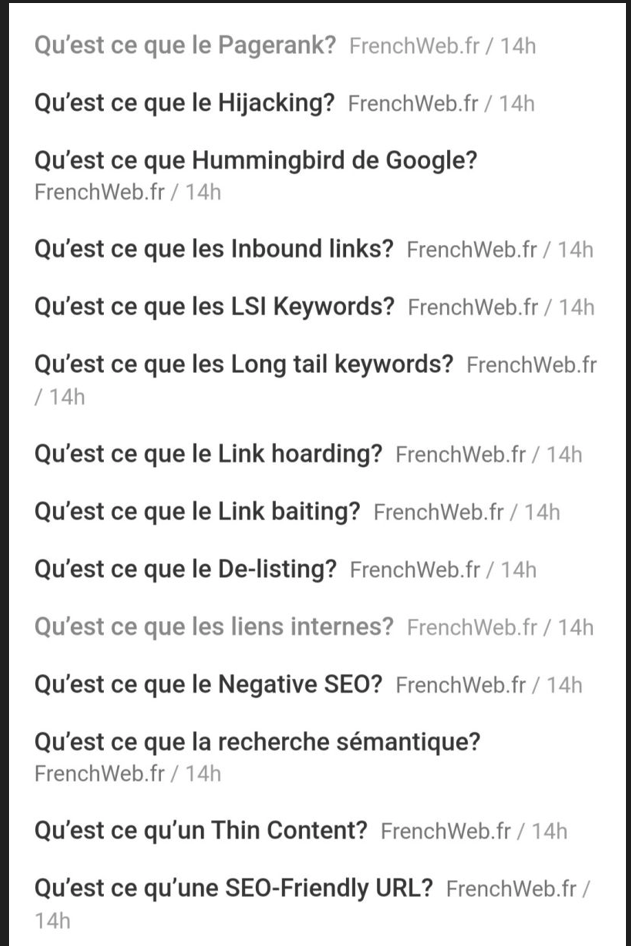

En proposant des IA génératives capables de produire des réponses structurées directement dans le résultat du moteur de recherche, Bing de Microsoft qui va vraisemblablement dégainer le premier (en outsider du search), lance aussi le premier outil qui envoie valdinguer les tables immuables de la loi de la recherche en ligne, et qui détruit les bases du search business tout en s'amusant à griffonner des hallucinations de graffitis sur les épîtres des apôtres du SEO.

Je m'apprêtais à enchaîner ici sur un vaste chapitre sur les enjeux actuels du SEO et te faire la pédagogie du business des médias dans les moteurs de recherche jusque 2022 mais, malheur du curateur de contenu, je me rends compte en cours d'écriture que Numerama vient de sortir ce 9 février un article plus complet que je ne saurais l'écrire, sur cette question. Merci Marie Turcan. Tu iras lire ce que l'équipe de Numerama en dit, c'est intéressant.

Voici avec Bing new génération que viennent des moteurs de recherche qui sont capables de donner la réponse à la question posée, directement, sans obliger le consommateur final à aller :

- se taper le lien dans une liste moche

- accepter les cookies,

- accepter les notifications de navigateur?

- accepter les paramètres Didomi, ou "continuer sans accepter"

- aller se créer un compte pour accéder à la vidé ou payer le paywall pour lire un article

- ....ah non mince c'est pas l'info que je cherchais,

- je recommence le même processus au lien 2.

Je caricature mais que celui qui n'a jamais pesté contre les pop-ups RGPD / Pub me jette la première pierre.

Des réponses directement dans les résultats du moteur de recherche. "Ceci est une révolution" des usages. Comme disait le porteur de col roulé qui n'était pas Bruno Lemaire.

Et attention je ne parle pas de réponses captées sur les sites des médias, et directement incises dans les résultats des moteur de recherche comme le fait Google jusqu'à présent, avec ses "excerpts" ou ses Accelerated Mobile Pages qui donnent le condensé du lien directement dans les résultats de recherche mobile (pratique qui a déclenché le tollé Cavada-ien sur le partage de revenus), sorte de bourbier économique ou Google essayait de contenter le consommateur, tout en le conservant dans son écosystème en tentant de ne pas se mettre trop à dos, les fournisseurs de décryptages d'actualité.

Non non je parle d'une réponse complète, cohérente, structurée en phrase et de la taille minimale d'un feuillet d'article de presse sans renvoi vers aucun site. Le tout "halluciné" par l'IA sur base d'un corpus de données source grand comme la taille de l'ensemble des médias francophones dans lesquels elle a fait son marché pour composer sa réponse "propre" et adaptée à la requête de l'internaute.

Une réponse faite de sources multiples qui, nouveau challenge pour Jean-Marie Cavada, se retrouve difficilement attaquable pour plagiat ou rupture de la directive sur les droits voisins. A moins d'une réponse très précise du moteur ou le corpus ne se trouve que dans un et un seul article existant en ligne, les procès en plagiat pour "hallucination sous influence" donneraient / -ont lieu à des échanges bizarres entre des avocats qui auront du mal à le prouver et des géants du search refusant de donner accès au code source de son outil, parce que la concurrence se servirait de cette donnée métier.

Mais pour le consommateur final, c'est vertigineux de potentiel.

Il ne sera plus obligé d'aller lire des sites de news, pour savoir ce qui s'est raconté entre le ballon chinois et le Pentagone, pour compléter cette info enrichie de toute l'histoire de l'espionnage aérien et même pour avoir une idée assez précise des conséquences possible de cet acte de survol d'un pays en froid économique avec l'autre.

Bye Bye les préconisations de la directive française sur les droits voisins acquises de haute lutte.

Oh wait... En fait, d'un coup d'un seul,

Bye bye l'économie des médias privés francophones bâtie en vingt années de test and learn du support numérique.

La guerre de l'IA contre les journalistes, va se jouer à un échelon au dessus du "bout de chaîne" que représente la rédaction d'un article. C'est là qu'il faut se dépêcher d'agir.

Dans un monde de l'info divisé en deux où s'oppose information de service public de moins en moins dotée par les gouvernement et économie des médias privés, c'est plutôt dans l'équilibre instable de la valeur financière des contenus médiatiques que l'IA risque de faire le plus de mal, à très court terme. Demain.

Depuis les années 2000 le modèle des médias numériques n'a pas beaucoup changé si on prétend, comme je le fais ici, que le passage du gratuit avec publicité au modèle avec paywall n'a pas occasionné de révolution majeure des usages (seulement un peu de transformation de la sociologie des lecteurs de chaque titre payant).

Pour accéder à la news en tant qu'internaute, on va toujours majoritairement taper un thème de recherche dans un moteur de recherche et le géant de la recherche qui détient cet outil répond à notre demande en nous envoyant des liens de sites web en réponses plus ou moins efficaces à notre demande initiale.

Le fonctionnement du moteur de recherche star (Google) n'a pas beaucoup changé non plus pour notre écosystème média. L'utilisateur tape une requête dans une barre de requête et se voit présenter une série de résultats composés pour la plupart de liens, où l'utilisateur trouvera une réponse à sa question, plus ou moins efficace, plus ou moins circonscrite (et Google propose au passage plein de sites qui se sont positionnés en mots-clés comme étant la réponse idéale à ce type de questions droit acquis auprès du géant en payant très cher sa place en haut de liste de résultats) :

"Google a bâti un empire en "polluant" ses résultats de recherche avec des publicités. Ses défenses peuvent sembler impénétrables, mais il a un point de faiblesse potentiel : un concurrent qui serait capable de donner aux utilisateurs des réponses plutôt que des liens vers des sites Web susceptibles d'avoir des réponses."Si tu as suivi les 20 dernières années des médias, tu te rappelles que de la création d'un portail Yahoo! au newsfeed inclus à Facebook en passant par l'avènement de Google actualités ou la récente bataille de Jean-Marie Cavada et de l'autorité de la concurrence contre Google... Tout l'enjeu du business des médias privés se joue dans le principe de partage de la valeur commerciale entre le géant du numérique qui propose l'outil moteur de recherche pour trier parmi des liens, l'apporteur de trafic depuis un portail à forte consultation et le créateur du contenu derrière ces liens: les articles de news en aval du clic.

(Article du Nieman's lab - 7 février 2023)

Tout est, depuis l'avènement des Gafam, affaire d'équilibre de pouvoir de générer des recettes et de balance du partage de revenus entre le fournisseur de chemin vers la news, et l'auteur de la news.

Les médias se sont donc battus pour pousser leurs liens vers les contenus dans chacun des silos des Gafam (la grande époque des médias financés par le visionnage de publicité, où plus de trafic entrant équivalait à plus de recettes publicitaires). Etre lu représentait un accroissement numéraire du nombre de publicités vues par l'internaute sur une page média. Il fallait donc être trouvable à chaque endroit où il était possible d'être trouvé.

Les Gafam en ont profité pour abuser de leur privilège de générateurs de volume et pour jouer aux dictateurs de formats, aux prescripteurs de règles ou de restrictions et de menaces de retirer les contenus du silo de leur walled garden.

Dans un second temps les médias privés et commerciaux se sont mis à tenter de rééquilibrer la relation entre celui qui croque financièrement au business de la redirection de trafic via recherche, et celui qui apporte du crédit, de la valeur aux recherches en fournissant un contenu news de qualité derrière chaque clic. Parce qu'investir dans un média, pour un investisseur, ça coûte cher. Et les perfusions étatiques ne permettent plus, ou à peine, d'augmenter les dividendes des actionnaires qui ont backé cet investissement.

Cette deuxième phase de l'internet des médias tenait pour acquis que le mode de fonctionnement de la recherche était gravé dans le marbre. C'était rigide comme des tables d'une loi tacite :

- Toi média tu te bats pour faire remonter ton lien en page 1 des moteurs de recherche,

- Toi média tu te bats avec Google pour qu'il partage un peu le brouzouf qu'il gagne sur les liens mis en exergue...

- Et toi consommateur tu cliques bien sagement sur les liens présentés en page une du moteur tu vas accepter les cookies tiers, acheter des contenus derrière des paywalls ou bouffer de la pub en préroll, avec un degré de satisfaction moyen. Degré de satisfaction bon pour le business de tout le monde puisqu'il t'amenait à passer d'un site à l'autre, d'un clic sur un résultat de recherche à l'autre.

Ce schéma d'usage semblait immuable.

En proposant des IA génératives capables de produire des réponses structurées directement dans le résultat du moteur de recherche, Bing de Microsoft qui va vraisemblablement dégainer le premier (en outsider du search), lance aussi le premier outil qui envoie valdinguer les tables immuables de la loi de la recherche en ligne, et qui détruit les bases du search business tout en s'amusant à griffonner des hallucinations de graffitis sur les épîtres des apôtres du SEO.

Je m'apprêtais à enchaîner ici sur un vaste chapitre sur les enjeux actuels du SEO et te faire la pédagogie du business des médias dans les moteurs de recherche jusque 2022 mais, malheur du curateur de contenu, je me rends compte en cours d'écriture que Numerama vient de sortir ce 9 février un article plus complet que je ne saurais l'écrire, sur cette question. Merci Marie Turcan. Tu iras lire ce que l'équipe de Numerama en dit, c'est intéressant.

« Le plus gros risque, c’est qu’il y ait un volume de clics largement réduit », résume Victor Glogowski, qui est responsable SEO du groupe Humanoid, à qui appartient Numerama. Le plus inquiétant ? « Descendre encore plus bas que la ‘ligne de flottaison’», nous explique-t-il — rapport au fameux comportement en « triangle » que l’on observe chez les internautes, qui ne cliquent en moyenne que dans une zone très restreinte, et plus du tout après quelques lignes.

(Article de Numerama - 9 février 2023)

Voici avec Bing new génération que viennent des moteurs de recherche qui sont capables de donner la réponse à la question posée, directement, sans obliger le consommateur final à aller :

- se taper le lien dans une liste moche

- accepter les cookies,

- accepter les notifications de navigateur?

- accepter les paramètres Didomi, ou "continuer sans accepter"

- aller se créer un compte pour accéder à la vidé ou payer le paywall pour lire un article

- ....ah non mince c'est pas l'info que je cherchais,

- je recommence le même processus au lien 2.

Je caricature mais que celui qui n'a jamais pesté contre les pop-ups RGPD / Pub me jette la première pierre.

Des réponses directement dans les résultats du moteur de recherche. "Ceci est une révolution" des usages. Comme disait le porteur de col roulé qui n'était pas Bruno Lemaire.

Et attention je ne parle pas de réponses captées sur les sites des médias, et directement incises dans les résultats des moteur de recherche comme le fait Google jusqu'à présent, avec ses "excerpts" ou ses Accelerated Mobile Pages qui donnent le condensé du lien directement dans les résultats de recherche mobile (pratique qui a déclenché le tollé Cavada-ien sur le partage de revenus), sorte de bourbier économique ou Google essayait de contenter le consommateur, tout en le conservant dans son écosystème en tentant de ne pas se mettre trop à dos, les fournisseurs de décryptages d'actualité.

Non non je parle d'une réponse complète, cohérente, structurée en phrase et de la taille minimale d'un feuillet d'article de presse sans renvoi vers aucun site. Le tout "halluciné" par l'IA sur base d'un corpus de données source grand comme la taille de l'ensemble des médias francophones dans lesquels elle a fait son marché pour composer sa réponse "propre" et adaptée à la requête de l'internaute.

Une réponse faite de sources multiples qui, nouveau challenge pour Jean-Marie Cavada, se retrouve difficilement attaquable pour plagiat ou rupture de la directive sur les droits voisins. A moins d'une réponse très précise du moteur ou le corpus ne se trouve que dans un et un seul article existant en ligne, les procès en plagiat pour "hallucination sous influence" donneraient / -ont lieu à des échanges bizarres entre des avocats qui auront du mal à le prouver et des géants du search refusant de donner accès au code source de son outil, parce que la concurrence se servirait de cette donnée métier.

Mais pour le consommateur final, c'est vertigineux de potentiel.

Il ne sera plus obligé d'aller lire des sites de news, pour savoir ce qui s'est raconté entre le ballon chinois et le Pentagone, pour compléter cette info enrichie de toute l'histoire de l'espionnage aérien et même pour avoir une idée assez précise des conséquences possible de cet acte de survol d'un pays en froid économique avec l'autre.

Bye Bye les préconisations de la directive française sur les droits voisins acquises de haute lutte.

Oh wait... En fait, d'un coup d'un seul,

Bye bye l'économie des médias privés francophones bâtie en vingt années de test and learn du support numérique.

Le moteur de recherche en média à part entière

Ainsi l'IA ne se substituera pas au journaliste de presse numérique non non... Le risque pour le journaliste n'est pas (encore) là; ils ont raison les matinaliers de France Inter . Non c'est simplement qu'elle ôtera au rédacteur, d'un coup d'un seul, les conditions de sa subsistance économique.

Parce que ton moteur de recherche deviendra média à part entière. Et ton taf de rédaction deviendra juste... Invisible. Donc économiquement non viable. Filtré, planqué par l'ingestion de cette "donnée de travail" dans le fonctionnement opératoire de l'intelligence artificielle qui produira la réponse à la question de l'internaute en compilant, ton article, celui de ton voisin, celui du cousin anglais traduit, etc. etc.

A quoi servira d'être l'Albert Londres de son média si le moteur de recherche par lequel on s'informe sur mettons : "quels sont les enjeux de la réforme des retraites et pourquoi le gouvernement s'arc boute-t-il sur son critère d'âge"... N'a plus besoin d'aller fournir une réponse par lien et peut se contenter de répondre tout seul ?

Si au lieu de renvoyer vers l'article de notre Bébert décrypteur de politique... Le moteur de recherche peut composer une réponse autonome nourrie de tous les Bébert Politologues de tous les médias hexagonaux et étrangers?

Dès lors comment Bébert Politologue pourra-t-il continuer à nourrir sa famille si la réponse est donnée par devers lui, et via une IA qui peut se doper en quelques secondes à toutes les sources existantes sur le sujet.

A quoi sert d'avoir négocié d'arrache-pied des accords bipartites avec Google News.... Si Bing ou Bard de Google (le nom commercial de Lamda -on sent que du coup Google n'est pas encore à l'aise sur ces questions-) ou un nouvel entrant, peut répondre sans avoir besoin de renvoyer vers un ou plusieurs médias?

Sans qu'il soit possible pour aucun des médias d'habitude rapides à attaquer les GAFAM qui se goinfrent d'ads sur le dos des contenus authentiques, de revendiquer le contenu qui est fourni en réponse. Puisque cette réponse sera une sorte de synthèse de toutes les réponses qui ont été données par quelques dizaines de médias différents.

N.B : Bard de Google risque d'avoir le cul entre deux chaises. Le géant vient de se taper les charges de l'autorité de la concurrence française, il a la possibilité technologique de réduire les aspirations de Jean-Marie Cavada à néant, mais il sait que s'il le fait il va devoir subir un retour de flamme médiatique et politique sans précédent.

Le moins qu'on puisse dire c'est que jusque là dans l'histoire de Google, ce n'est pas le sentiment de "responsabilité" vis à vis des médias qui a prévalu mais imaginons que le géant soit sincère. Microsoft avec ses parts de marché du search toutes riquiquis aura-t-il la même conscience médiatique? Et les nouveaux acteurs auront-ils seulement une conscience sur le sujet?

Puis quid des acteurs alternatifs qui entraîneront leurs IA génératives à un mélange de bases de données "des médias" et des "médias alternatifs" (complotisme, antivas, Qanon...) ou pire qui ne les abreuveront qu'à des sources "officielles". A quoi ressemblera la réponse du moteur de recherche russe (avec ou sans contournement VPN) à la question "les opérations spéciales en Ukraine sont elles une guerre de notre pays avec cette république?" ou chinois quand il sera question de libre expression. A quoi ressemblera le search bot du libertarien Elon Musk si son corpus se limite aux données produites par un Twitter qui perd petit à petit ses démocrates et ses "socialists"?

Parce que ton moteur de recherche deviendra média à part entière. Et ton taf de rédaction deviendra juste... Invisible. Donc économiquement non viable. Filtré, planqué par l'ingestion de cette "donnée de travail" dans le fonctionnement opératoire de l'intelligence artificielle qui produira la réponse à la question de l'internaute en compilant, ton article, celui de ton voisin, celui du cousin anglais traduit, etc. etc.

A quoi servira d'être l'Albert Londres de son média si le moteur de recherche par lequel on s'informe sur mettons : "quels sont les enjeux de la réforme des retraites et pourquoi le gouvernement s'arc boute-t-il sur son critère d'âge"... N'a plus besoin d'aller fournir une réponse par lien et peut se contenter de répondre tout seul ?

Si au lieu de renvoyer vers l'article de notre Bébert décrypteur de politique... Le moteur de recherche peut composer une réponse autonome nourrie de tous les Bébert Politologues de tous les médias hexagonaux et étrangers?

Dès lors comment Bébert Politologue pourra-t-il continuer à nourrir sa famille si la réponse est donnée par devers lui, et via une IA qui peut se doper en quelques secondes à toutes les sources existantes sur le sujet.

A quoi sert d'avoir négocié d'arrache-pied des accords bipartites avec Google News.... Si Bing ou Bard de Google (le nom commercial de Lamda -on sent que du coup Google n'est pas encore à l'aise sur ces questions-) ou un nouvel entrant, peut répondre sans avoir besoin de renvoyer vers un ou plusieurs médias?

Sans qu'il soit possible pour aucun des médias d'habitude rapides à attaquer les GAFAM qui se goinfrent d'ads sur le dos des contenus authentiques, de revendiquer le contenu qui est fourni en réponse. Puisque cette réponse sera une sorte de synthèse de toutes les réponses qui ont été données par quelques dizaines de médias différents.

N.B : Bard de Google risque d'avoir le cul entre deux chaises. Le géant vient de se taper les charges de l'autorité de la concurrence française, il a la possibilité technologique de réduire les aspirations de Jean-Marie Cavada à néant, mais il sait que s'il le fait il va devoir subir un retour de flamme médiatique et politique sans précédent.

« Nous sommes conscients de notre responsabilité », a tenu à rassurer Prabhakar Raghavan, le patron du « search » chez Google, au cours d’une conférence le 8 février 2022 à laquelle Numerama a assisté.

Le moins qu'on puisse dire c'est que jusque là dans l'histoire de Google, ce n'est pas le sentiment de "responsabilité" vis à vis des médias qui a prévalu mais imaginons que le géant soit sincère. Microsoft avec ses parts de marché du search toutes riquiquis aura-t-il la même conscience médiatique? Et les nouveaux acteurs auront-ils seulement une conscience sur le sujet?

Puis quid des acteurs alternatifs qui entraîneront leurs IA génératives à un mélange de bases de données "des médias" et des "médias alternatifs" (complotisme, antivas, Qanon...) ou pire qui ne les abreuveront qu'à des sources "officielles". A quoi ressemblera la réponse du moteur de recherche russe (avec ou sans contournement VPN) à la question "les opérations spéciales en Ukraine sont elles une guerre de notre pays avec cette république?" ou chinois quand il sera question de libre expression. A quoi ressemblera le search bot du libertarien Elon Musk si son corpus se limite aux données produites par un Twitter qui perd petit à petit ses démocrates et ses "socialists"?

Et pourtant il y a un vrai avantage pour le consommateur final

"quels sont les enjeux de la réforme des retraites et pourquoi le gouvernement s'arc boute-t-il sur son critère d'âge selon une vision socio démocrate" ;

"quels sont les enjeux de la réforme des retraites et pourquoi le gouvernement s'arc boute-t-il sur son critère d'âge, selon l'aile gauche de l'opinion publique.....

"Pourquoi les LR soutiennent la réforme des retraites mais sans que le gouvernement ne s'appuie sur leurs recommandations?"

Plus les prompts seront précis (donc plus les questions des internautes seront précises) et plus la réponse sera pertinente pour le surfeur de web. Plus l'intelligence artificielle se sera auto-entrâinée. Le tout sans que l'internaute ait quitté l'interface de recherche.

Ou mieux encore, sans même avoir besoin de cette interface : "Ok Google peux-tu me dire pourquoi Aurore Bergé explique que taxer les riches ça ne marche pas, dans le cadre des arguments qu'elle donne en faveur de la réforme des retraites"

Pour le lecteur final c'est un bond en avant énorme. Ou en tous cas la promesse d'un potentiel bond en avant énorme en matière d'user expérience de la recherche.

Une question précise appelle une réponse concrète et adaptée à la question. Et le système neuronal de l'IA s'enrichit du degré de satisfaction de l'utilisateur final ou de la forme qu'a prise la question posée.

"quels sont les enjeux de la réforme des retraites et pourquoi le gouvernement s'arc boute-t-il sur son critère d'âge, selon l'aile gauche de l'opinion publique.....

"Pourquoi les LR soutiennent la réforme des retraites mais sans que le gouvernement ne s'appuie sur leurs recommandations?"

Plus les prompts seront précis (donc plus les questions des internautes seront précises) et plus la réponse sera pertinente pour le surfeur de web. Plus l'intelligence artificielle se sera auto-entrâinée. Le tout sans que l'internaute ait quitté l'interface de recherche.

Ou mieux encore, sans même avoir besoin de cette interface : "Ok Google peux-tu me dire pourquoi Aurore Bergé explique que taxer les riches ça ne marche pas, dans le cadre des arguments qu'elle donne en faveur de la réforme des retraites"

Pour le lecteur final c'est un bond en avant énorme. Ou en tous cas la promesse d'un potentiel bond en avant énorme en matière d'user expérience de la recherche.

Une question précise appelle une réponse concrète et adaptée à la question. Et le système neuronal de l'IA s'enrichit du degré de satisfaction de l'utilisateur final ou de la forme qu'a prise la question posée.

Pivoter ou disparaître ?

Cependant, pour les médias, on l'a vu plus haut, le seul bénéfice à moyenne échéance consiste à pouvoir traiter l'info en temps réel à moindre coût, pour des articles factuels à faible degré informatif répondant à l'exigence du temps réel.

Je suis prêt à parier qu'on s'étonnerait assez peu, finalement, après quelques plans de sauvegarde de l'emploi que la hot news passe quasi directement des agences de presse à la rédaction automatique via l'abonnement à chat gpt ou autre et sous le contrôle d'un SR.

Mais, pour arriver à ce stade, il faudra cependant que les médias aient les reins assez solides pour supporter le changement qui arrive à toute vitesse du côté des moteurs de recherche. Ils ont plus à perdre de la déchéance du modèle du search, que des bénéfices commerciaux de l'automatisation du traitement journalistique de contenu à faible valeur ajoutée au sein de la rédaction.

L'enjeu de l'IA pour les médias est celui du pivotement sectoriel lié à un changement rapide des règles du jeu du search

Dans le meilleur des cas de figure, celui où les acteurs du search se montrent responsables, et où le monde du journalisme pivote rapidement. Le journaliste redevient un métier d'expertise en matière de savoir et de savoir faire. Y compte la bouteille, la bonne connaissance thématique, le réseau d'informateurs, l'enquête fouillée ou la curation de contenu personnalisée, émotionnelle. Soit en gros tout ce qui sera difficilement accessible à un algorithme génératif neuronal à courte échéance.

Dans ce monde il deviendra encore plus dur à un(e) jeune journaliste de faire ses premières armes sans d'abord faire ses preuves en sortant un long format étayé, construit, unique dans le fond et la forme. Et de s'être nourri(e) de pâtes au sel en attendant.

Dans un scénario, plus sombre, l'économie des médias ne résiste pas à la rapidité d'évolution des méthodes search et les réponses construites par les moteurs de recherche ne laissent pas au secteur le temps pour que ce "switch de l'expertise" s'opère. Ou pire scénario encore, les acteurs médias ne se rendent pas compte assez vite qu'un mouvement de modification des usages de la recherche est en cours et ils continuent à vivre de routine opératoire renforcée par l'expérience de 20 années d'immobilisme en la matière. lls continuent de fournir pro deo toute leur matière première à un opérateur du search historique par lien, permettant à son IA générative en embuscade, de s'entraîner sur des sets de données réelles et évolutives.

Dans ce cas de cécité mi contrainte mi débonnaire, les recettes s'évaporent plus vite que ne s'opère la transformation du métier de journaliste vers l'expertise rédactionnelle (le ton, la plume, le savoir, l'angle, le traitement, la compilation maline, qu'on vient chercher directement sur un titre média, plutôt que le demander à son assistant de recherche).

Dans ce worst case scénario les médias ne se rendent pas compte que la clé de leur viabilié sans le search consiste en fait à rapidement affermir leur ligne éditoriale, leur identité de contenu pour devenir ou redevenir des référents thématiques qu'on vient consulter en réflexe d'information, par affinité, hors search bar. "il en dit quoi le Huff?" "Ils ont débunké ça chez Julien Pain ?" "ils ont fait leur une sur quoi du Le Fig." etc ne redeviennent pas des réflexes d'usage informationnels par le public. Et les médias continuent, pendant le temps toléré par les actionnaires des titres de presse, de financer à perte des articles ou des contenus que plus personne n'atteint.

Scénario du pire toujours, les titres privés tombent les uns après les autres au nom de la quête de rentabilité demandée par l'actionnariat de ces médias, devenus trop "non rentables". Les procès sont intentés tardivement et perdus. L'usage de cliquer vers un lien d'actu devient anecdotique.

Scénario uchronique. Au stade de leur mort cérébrale ils sont cependant maintenus en vie par lesdits actionnariats, avec la seule motivation de fournir des corpus partisans aux IA, pour les entraîner à leur insu. Le journalisme devient une sorte de communication d'entreprise. Personne ne lit plus les articles mais au moins ce qui se dit sur Dassault part d'un corpus maîtrisé. La coloration du corpus d'information soumise aux IA des géants du search devient la seule motivation de l'actionnariat des titres médias. Le monde change, façonné par les réponses des IA à des questions anodines posées par les internautes et gavées d'une base de données évoluant de manière de plus en plus partisane.

Dans ce schéma, l'information de service public continue d'apporter un contrepoint. Oui mais noyé comme un des apports au discours restitué dans la réponse de l'IA, entré en compétition dans la base de données, avec des acteurs de la désinformation ou des intérêts privés, étrangers du genre qui pourraient avoir intérêt à orienter les réponses de l'IA en la nourrissant d'informations tronquées.

Je suis prêt à parier qu'on s'étonnerait assez peu, finalement, après quelques plans de sauvegarde de l'emploi que la hot news passe quasi directement des agences de presse à la rédaction automatique via l'abonnement à chat gpt ou autre et sous le contrôle d'un SR.

Mais, pour arriver à ce stade, il faudra cependant que les médias aient les reins assez solides pour supporter le changement qui arrive à toute vitesse du côté des moteurs de recherche. Ils ont plus à perdre de la déchéance du modèle du search, que des bénéfices commerciaux de l'automatisation du traitement journalistique de contenu à faible valeur ajoutée au sein de la rédaction.

L'enjeu de l'IA pour les médias est celui du pivotement sectoriel lié à un changement rapide des règles du jeu du search

Dans le meilleur des cas de figure, celui où les acteurs du search se montrent responsables, et où le monde du journalisme pivote rapidement. Le journaliste redevient un métier d'expertise en matière de savoir et de savoir faire. Y compte la bouteille, la bonne connaissance thématique, le réseau d'informateurs, l'enquête fouillée ou la curation de contenu personnalisée, émotionnelle. Soit en gros tout ce qui sera difficilement accessible à un algorithme génératif neuronal à courte échéance.

Dans ce monde il deviendra encore plus dur à un(e) jeune journaliste de faire ses premières armes sans d'abord faire ses preuves en sortant un long format étayé, construit, unique dans le fond et la forme. Et de s'être nourri(e) de pâtes au sel en attendant.

Dans un scénario, plus sombre, l'économie des médias ne résiste pas à la rapidité d'évolution des méthodes search et les réponses construites par les moteurs de recherche ne laissent pas au secteur le temps pour que ce "switch de l'expertise" s'opère. Ou pire scénario encore, les acteurs médias ne se rendent pas compte assez vite qu'un mouvement de modification des usages de la recherche est en cours et ils continuent à vivre de routine opératoire renforcée par l'expérience de 20 années d'immobilisme en la matière. lls continuent de fournir pro deo toute leur matière première à un opérateur du search historique par lien, permettant à son IA générative en embuscade, de s'entraîner sur des sets de données réelles et évolutives.

Les médias, qui sont déjà fortement dépendants de Google, se voient désormais confrontés à ce nouveau problème : fournir toute la matière textuelle à des moteurs de recherche (les articles que Google Bard va résumer), sans en avoir les bénéfices (l’audience).

(Numerama)

Dans ce cas de cécité mi contrainte mi débonnaire, les recettes s'évaporent plus vite que ne s'opère la transformation du métier de journaliste vers l'expertise rédactionnelle (le ton, la plume, le savoir, l'angle, le traitement, la compilation maline, qu'on vient chercher directement sur un titre média, plutôt que le demander à son assistant de recherche).

Dans ce worst case scénario les médias ne se rendent pas compte que la clé de leur viabilié sans le search consiste en fait à rapidement affermir leur ligne éditoriale, leur identité de contenu pour devenir ou redevenir des référents thématiques qu'on vient consulter en réflexe d'information, par affinité, hors search bar. "il en dit quoi le Huff?" "Ils ont débunké ça chez Julien Pain ?" "ils ont fait leur une sur quoi du Le Fig." etc ne redeviennent pas des réflexes d'usage informationnels par le public. Et les médias continuent, pendant le temps toléré par les actionnaires des titres de presse, de financer à perte des articles ou des contenus que plus personne n'atteint.

Scénario du pire toujours, les titres privés tombent les uns après les autres au nom de la quête de rentabilité demandée par l'actionnariat de ces médias, devenus trop "non rentables". Les procès sont intentés tardivement et perdus. L'usage de cliquer vers un lien d'actu devient anecdotique.

Scénario uchronique. Au stade de leur mort cérébrale ils sont cependant maintenus en vie par lesdits actionnariats, avec la seule motivation de fournir des corpus partisans aux IA, pour les entraîner à leur insu. Le journalisme devient une sorte de communication d'entreprise. Personne ne lit plus les articles mais au moins ce qui se dit sur Dassault part d'un corpus maîtrisé. La coloration du corpus d'information soumise aux IA des géants du search devient la seule motivation de l'actionnariat des titres médias. Le monde change, façonné par les réponses des IA à des questions anodines posées par les internautes et gavées d'une base de données évoluant de manière de plus en plus partisane.

Dans ce schéma, l'information de service public continue d'apporter un contrepoint. Oui mais noyé comme un des apports au discours restitué dans la réponse de l'IA, entré en compétition dans la base de données, avec des acteurs de la désinformation ou des intérêts privés, étrangers du genre qui pourraient avoir intérêt à orienter les réponses de l'IA en la nourrissant d'informations tronquées.

Pivoter et réguler

L'inquiétude majeure qui devrait occuper les journalistes qui glosent l'arrivée des ia génératives conversationnelles dans le secteur des médias, serait d'amener leurs patrons à vérifier si l'économie des titres numériques, le leur et tous les autres, est parée à résister à l'absence de clic via les moteurs de recherche. A amener les pouvoirs publics à se saisir de la question en amont du lobbying que les Gafam ne manqueront pas de mettre en place.

Soit ralentir le processus le temps nécessaire à ce que s'opère une transformation de la forme et de la méthode de l'accès aux médias (au hasard, via les apps des médias : voici un outil qu'on ne cherche pas mais qui nous trouve par notification dans notre poche, qu'on a téléchargé par conviction dans les rayonnages de son téléphone et qui vit sans le search).

Et tandis que lui sera coupé pendant cet exercice de pivotement, une grande partie du pipeline de clics vers les paywalls ou les offres avec publicité, prévoir les business plans de transformations numériques qui vont bien.

La question qui doit s'imposer à Jean-Marie Cavada mais aussi aux acteurs des médias européens, dans les prochains jours de 2023 est celle de la création de ralentisseurs de cette transformation du search, notamment par la régulation rapide des pratiques d'entraînement et de sourcing de contenus des IA à portée informative.

Mais a-t-on un seul exemple dans la courte histoire du numérique des médias de la mise en place d'une régulation rapide et concertée à l'échelle d'un territoire grand comme l'Union Européenne? Une régulation juste qui laisse l'Europe suffisamment attractive dans la promesse de business pour qu'elle puisse forcer les Gafam à modifier le cours de leur perspective commerciale et de leur concurrence (genre demain puisque Bing annonce ses premiers tests et Google aussi). Tout en empêchant en même temps le tarissement des sources de revenus pour les médias, avant qu'ils n'aient eu le temps de changer leurs pratiques de business?

Thierry Breton, le commissaire européen responsable au marché intérieur, appelé à s’exprimer sur le phénomène du moment a salué les grandes opportunités offertes par l’IA, mais aussi rappelé la nécessité de l’encadrer par un cadre réglementaire adéquat. (...) Pour Thierry Breton, ces risques prouvent que « nous avons besoin d'un cadre réglementaire solide pour garantir une IA digne de confiance basée sur des données de haute qualité ». Le commissaire européen plaide notamment pour de « La transparence » pour faire face au « risque de partialité et de diffusion de fausses informations ».S'il ne s'agit, comme je m'y attends malheureusement, que d'une réponse purement commerciale et désordonnée, titre média par titre média? "Ok Bill Gates, on dit rien mais en bas de la réponse de Bing tu mets : pour en savoir plus retrouvez l'article super moumoute de Bébert Politologue chez le Gorafi. " La bataille pour la survie risque d'être perdue pour un grand nombre d'acteurs médias qui n'arriveront pas à négocier leur place dans les rares zones tolérées par Bing ou Bard.

(Siècle Digital)

Le plus affreux est que du newsfeed de facebook à la gestion désordonnées des accords des médias concernant les droits voisins chez Google, le passé nous a montré que le secteur ne fait pas corps pour limiter les impacts d'une nouvelle technologie sur ses métiers fondateurs.

Cette démarche du chacun pour soi, dans le grand mouvement de modification du search ne peut qu'être délétère. Elle remet la position de force sur les Gafam (tu veux un petit lien en bas de texte généré ou tu te brosses?). Elle affaiblit tout un secteur jusqu'au risque de sa disparition pure et simple.

J'ai, de ma petite lorgnette de curateur d'information avec un tropisme pour les médias, l'impression que le secteur n'a pas encore évalué totalement la nature du terrain où se déroulera la bataille de l'IA pour le secteur.

Les métiers seront impactés, certes, mais la viabilité des titres de presse pourrait être remise en cause bien avant que ne soit réellement questionnée la nécessité des métiers qui la composent. J'en viens à me dire que seuls les géants du search (dont l'iA reste pertinente uniquement si elle peut se nourrir d'un corpus varié) vont prendre des mesures de régulation permettant de sauver suffisamment les moutons médias, dont l'IA vient à intervalle régulier tondre la laine.

Brillante mise en situation par le Nieman Lab (en Anglais) sur le sujet.

Ou alors je vois trop l'horizon en noir. L'internet de la recherche de liens n'est pas mort, et je devrais identifier des signes de fiasco dans les récents déboires de Google lors de la présentation de Bard en France. Possible.

Dans sa présentation de Lamda en France, Sundar Pinchai a évoqué l'efficacité de l'IA de Google pour éveiller la découverte et la créativité. Il a assorti cette démonstration d'une vidéo montrant l'efficacité de l'IA de Google à répondre aux questions d'un enfant de 9 ans sur les découvertes du télescope James Webb. Selon cette dernière : James Webb ST a pris les toutes premières photos d'une planète en dehors de notre propre système solaire. Seulement voilà la première image d'une exoplanète en dehors du système solaire a été capturée en 2004 par le réseau du Very Large Telescope au Chili. Oups.

Pourquoi ais-je cet extrait de la série parodique Silicon Valley en tête :-) ?

Un couac lors de la présentation qui n'est pas passé inaperçu des trublions dans mon genre. Et des investisseurs. Le cours de l'action de la société Alphabet, maison mère de Lamda/bard a chuté de 8% après le lancement de l'outil Google Bard. L'action se négociait à 98,08$ mercredi juste après le lancement, soit une baisse de 8,1% par rapport au prix de la veille où l'action s'échangeait à 106,77$, ce qui correspond, selon le Telegraph, à une perte de 120 milliards de dollars. Preuve que le sujet de l'IA est tendance, et que les attentes sont énormes.

Au vu des valorisations et des montants investis, j'ai malheureusement l'impression que les investisseurs ne resteront pas sur un échec, et que les médias sont face à la situation de pivot immédiat, mais ne s'en rendent pas encore compte. Parce que Bard lui, va améliorer et corriger son corpus.

Et vous vous en pensez quoi? Venez en débattre dans le discord .

Pourquoi ais-je cet extrait de la série parodique Silicon Valley en tête :-) ?

Un couac lors de la présentation qui n'est pas passé inaperçu des trublions dans mon genre. Et des investisseurs. Le cours de l'action de la société Alphabet, maison mère de Lamda/bard a chuté de 8% après le lancement de l'outil Google Bard. L'action se négociait à 98,08$ mercredi juste après le lancement, soit une baisse de 8,1% par rapport au prix de la veille où l'action s'échangeait à 106,77$, ce qui correspond, selon le Telegraph, à une perte de 120 milliards de dollars. Preuve que le sujet de l'IA est tendance, et que les attentes sont énormes.

Au vu des valorisations et des montants investis, j'ai malheureusement l'impression que les investisseurs ne resteront pas sur un échec, et que les médias sont face à la situation de pivot immédiat, mais ne s'en rendent pas encore compte. Parce que Bard lui, va améliorer et corriger son corpus.

Et vous vous en pensez quoi? Venez en débattre dans le discord .

En faire plus avec l'IA en matière de journalisme :

- Liste d'outils pour journalistes et médias dopés à l'iA : par Julien Metayer

- De bonnes ressources pour #ChatGPT en français rassemblées par Matthieu Corthésy

Technologies

Technologies

Réseaux sociaux : l’Assemblée nationale adopte l’interdiction pour les moins de 15 ans

Réseaux sociaux : l’Assemblée nationale adopte l’interdiction pour les moins de 15 ans